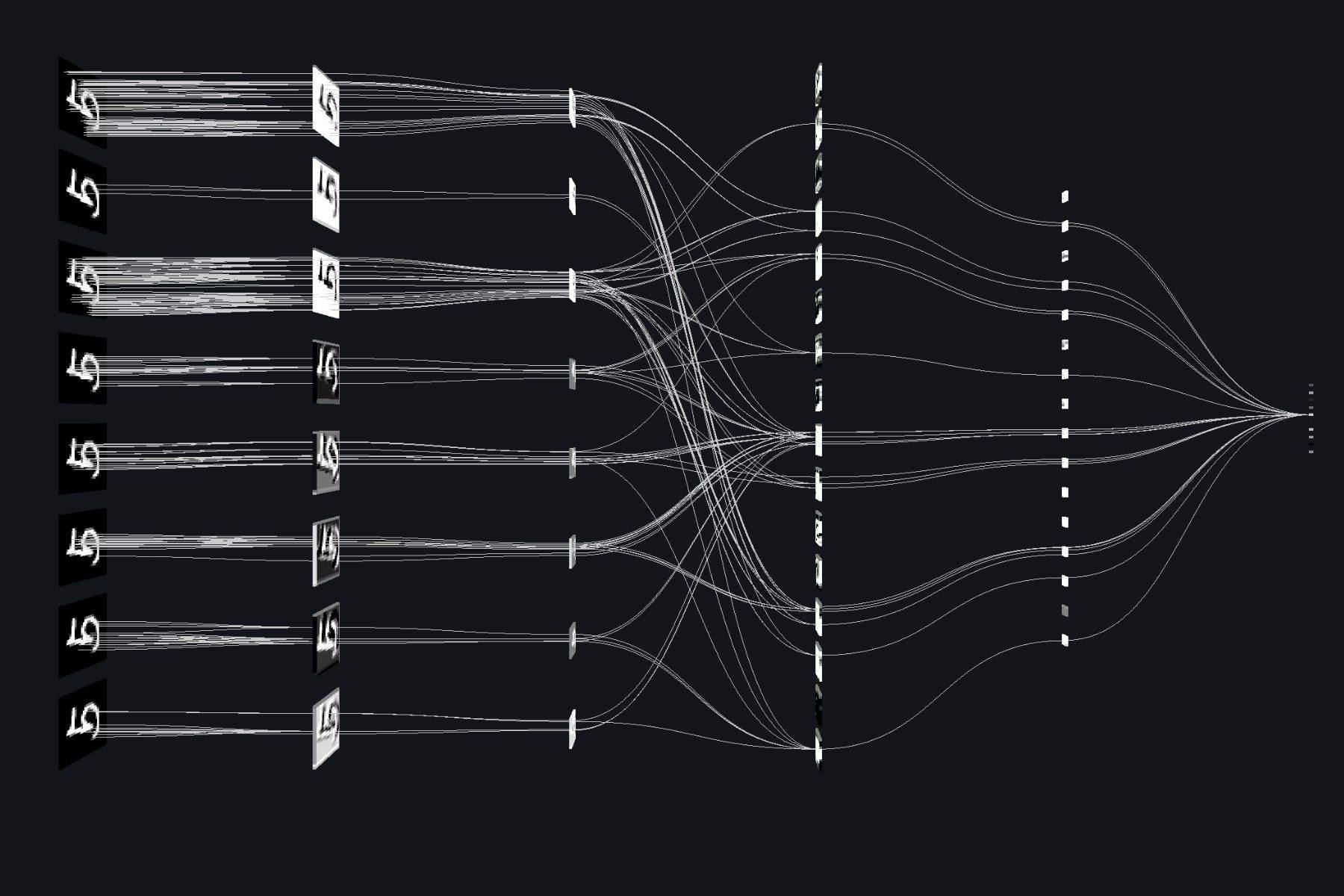

《机器学习》 西瓜书习题 第 5 章: 神经网络

习题5.1试述将线性函数 $$f(\boldsymbol{x}) = \boldsymbol{w}^{\mathrm{T}}\boldsymbol{x}$$ 用作神经元激活函数的缺陷.

理想中的激活函数是阶跃函数, 但是它不连续, 不光滑, 所以要一个连续、光滑的函数替代它. 线性函数虽然连续、光滑, 但是它跟阶跃函数并不是那么相似. 线性函数对 $$0$$ 周围的数值和对趋近 $$\infty$$ 的数值是一视同仁的, 而这样的性质我们并不需要, 我们更在乎那些处于 $$0$$ 周围的, 在被分为正 (大于 $$0$$ ) 还是负 (小于 $$0$$ ) 的界限边的 ‘模糊’ 的数值, 因此有了 $$\mathrm{Sigmoid}$$ 函数, 它的特点就是在 $$0$$ 周围输出急剧变化.

5.2试述使用图 $$5.2(\mathrm{b})$$ 激活函数的神经元与对率回归的联系.

这已经非常明显了, 対率回归的激活函数也是 $$Sigmoid$$ .

5.3对于图 $$5.7$$ 中的 $$v_{ih}$$ 试推导出 $$\mathrm{BP}$$ 算法中的更新公式 $$(5.1 ...

《机器学习》 西瓜书实例 第 4 章: 决策树

《机器学习》 西瓜书的代码实现.

《机器学习》 西瓜书实例 第 4 章

/*!

*

* Twitter Bootstrap

*

*/

/*!

* Bootstrap v3.3.7 (http://getbootstrap.com)

* Copyright 2011-2016 Twitter, Inc.

* Licensed under MIT (https://github.com/twbs/bootstrap/blob/master/LICENSE)

*/

/*! normalize.css v3.0.3 | MIT License | github.com/necolas/normalize.css */

html {

font-family: sans-serif;

-ms-text-size-adjust: 100%;

-webkit-text-size-adjust: 100%;

}

body {

margin: 0;

}

article,

aside,

details,

figcaption,

figure,

foot ...

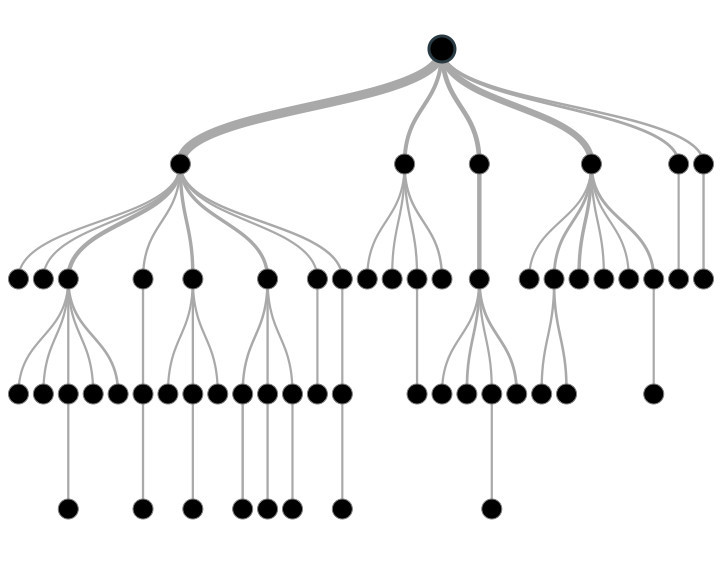

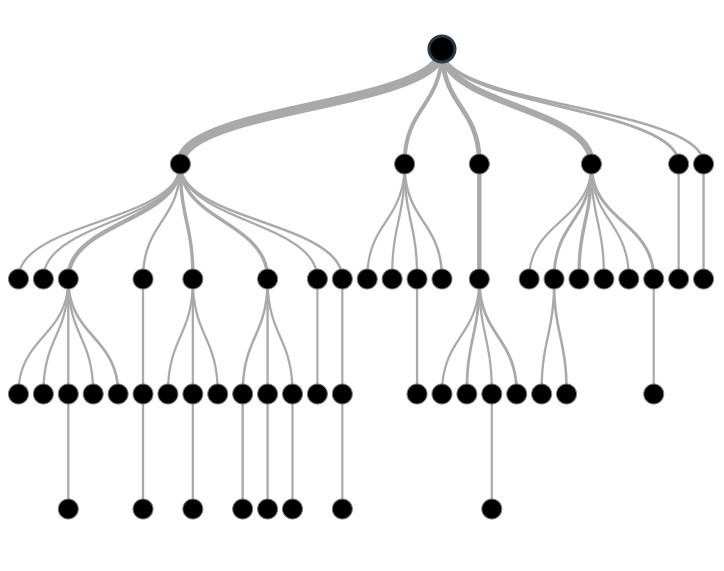

《机器学习》 西瓜书习题 第 4 章: 决策树

习题4.1试证明对于不含冲突数据 (即特征向量完全相同但标记不同) 的训练集, 必存在与训练集一致 (即训练误差为 0)的决策树.

既然每个标记不同的数据特征向量都不同, 只要树的每一条 (从根解点到一个叶节点算一条) 枝干代表一种向量, 这个决策树就与训练集一致.

4.2试析使用 “最小训练误差” 作为决策树划分选择准则的缺陷.

$4.1$ 说明了如果数据不冲突, 可以完全拟合数据集, 这正是使用 “最小训练误差” 作为决策树划分选择准则的结果. 而这是绝对的过拟合.

4.3试编程实现基于信息熵进行划分选择的决策树算法, 并为表 $4.3$ 中数据生成一棵决策树.

《机器学习》西瓜书 第 3 章 编程实例

4.4试编程实现基于基尼指数进行划分选择的决策树算法, 为表 $4.2$ 中数据生成预剪枝、后剪枝决策树, 并与未剪枝决策树进行比较.

《机器学习》西瓜书 第 3 章 编程实例

4.5试编程实现基于対率回归进行划分选择的决策树算法, 并为表 $4.3$ 中数据生成一棵决策树.

《机器学习》西瓜书 第 3 章 编程实例

4.6试选择 $4$ 个 $\mathrm{UCI} ...

《机器学习》 西瓜书实例 第 3 章: 线性模型

《机器学习》 西瓜书的代码实现.

《机器学习》 西瓜书实例 第 3 章

/*!

*

* Twitter Bootstrap

*

*/

/*!

* Bootstrap v3.3.7 (http://getbootstrap.com)

* Copyright 2011-2016 Twitter, Inc.

* Licensed under MIT (https://github.com/twbs/bootstrap/blob/master/LICENSE)

*/

/*! normalize.css v3.0.3 | MIT License | github.com/necolas/normalize.css */

html {

font-family: sans-serif;

-ms-text-size-adjust: 100%;

-webkit-text-size-adjust: 100%;

}

body {

margin: 0;

}

article,

aside,

details,

figcaption,

figure,

foote ...

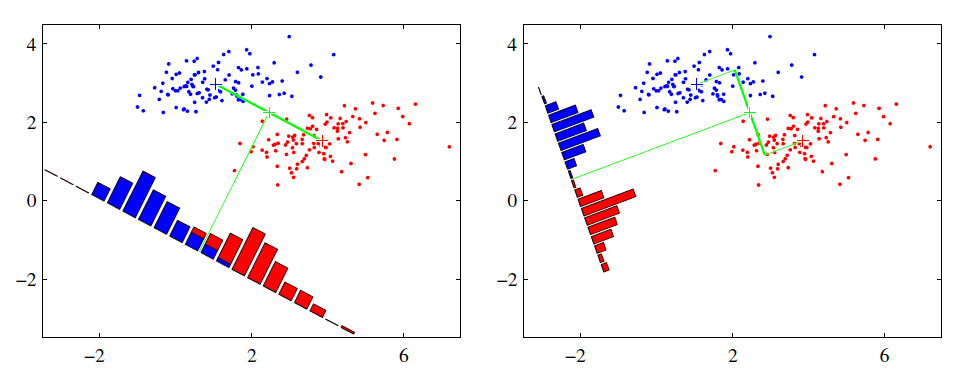

《机器学习》 西瓜书习题 第 3 章: 线性模型

习题3.1试析在什么情况下式 $(3.2)$ 中不必考虑偏置项 $b$ .

书中有提到, 可以把 $x$ 和 $b$ 吸收入向量形式 $\hat{w} = (w;b)$ .此时就不用单独考虑 $b$ 了.

其实还有很多情况不用, 比如说使用了 $\mathrm{one-hot}$ 编码, 就可以不用考虑偏置项.

更广泛的情况是, 如果偏置项 $b$ 可以被 “包含” 在另外的一些离散特征里, 那么就不用考虑. 就是偏置项可以以一定系数加到离散特征中. (可能看了还是不太懂, 我以后有时间会重写一个的.)

3.2试证明, 对于参数 $w$, 对率回归的目标函数 $(3.18)$ 是非凸的, 但其对数似然函数 $(3.27)$ 是凸的.

$$

y = \frac{1}{1 + e^{-(\boldsymbol w^\mathrm T\boldsymbol x + b)}}\tag{3.18}

$$

$$

\ell(\boldsymbol\beta) = \sum^m_{i = 1}(-y_i\boldsymbol \beta^\mathrm T\boldsymbol{\hat{x}}_i) ...

《机器学习》 西瓜书实例 第 2 章: 模型评估与选择

《机器学习》 西瓜书的代码实现.

《机器学习》 西瓜书实例 第 2 章

/*!

*

* Twitter Bootstrap

*

*/

/*!

* Bootstrap v3.3.7 (http://getbootstrap.com)

* Copyright 2011-2016 Twitter, Inc.

* Licensed under MIT (https://github.com/twbs/bootstrap/blob/master/LICENSE)

*/

/*! normalize.css v3.0.3 | MIT License | github.com/necolas/normalize.css */

html {

font-family: sans-serif;

-ms-text-size-adjust: 100%;

-webkit-text-size-adjust: 100%;

}

body {

margin: 0;

}

article,

aside,

details,

figcaption,

figure,

foote ...

《机器学习》 西瓜书习题 第 2 章: 模型评估与选择

习题2.1数据集包含 $1000$ 个样本, 其中 $500$ 个正例、$500$ 个反例, 将其划分为包含 $70\%$ 样本的训练集和 $30\%$ 样本的测试集用于留出法评估, 试估算共有多少种划分方式.

如果划分要保证正例和反例一样多的话, 那么划分方式数量 $n$ 有$$

\begin{aligned}

n &= C^{500\times35\%}{500}\times C{500}^{500\times 35\%}\\\\

&=(C^{175}_{500})^{2}

\end{aligned}

$$如果不考虑的话则有$$

n = C^{500\times 70\%}_{500}=C^{350}_{500}

$$

2.3数据集包含 $100$ 个样本, 其中正、反例各一半, 假定学习算法所产生的模型是将新样本预测为训练样本数较多的类别 (训练样本数相同时进行随机猜测) , 试给出用 $10$ 折交叉验证法和留一法分别对错误率进行评估所得的结果.

$10$ 折交叉验证, 我们认为划分是随意的, 那么根据对称性可知, 对于每个子集来说正例更多的概率为 $\fra ...

《机器学习》 西瓜书习题 第 1 章: 绪论

习题1.1表 $1.1$ 中若只包含编号为 $1$ 和 $4$ 的两个样例, 试给出相应的版本空间.

这应该不难理解吧,直接上表格.

编号

色泽

根蒂

敲声

好瓜

$1$

青绿

蜷缩

浊响

是

$4$

乌黑

稍蜷

沉闷

否

1.2与使用单个合取式来进行假设表示相比, 使用 “析合范式” 将使得假设空间具有更强的表示能力. 例如$$

好瓜 \leftrightarrow \big((色泽=*)\wedge(根蒂=蜷缩)\wedge(敲声=*)\big)\vee\big((色泽=乌黑)\wedge(根蒂=*)\wedge(敲声=沉闷)\big)

$$*会把 “$(色泽=*)\wedge(根蒂=蜷缩)\wedge(敲声=*)\,$$" 以及 "$(色泽=乌黑)\wedge(根蒂=)\wedge(敲声=沉闷)\,$$" 都分类为 "好瓜" . 若使用最多包含 $k\,$$ 个合取式的析合范式来表达 $1.1\,$$ 西瓜分类问题的假设空间, 试估算共有多少种可能的假设.**

一共有 $3$ 个特征, 第一个特征有 $3$ 种取值(算上 $$ ), 第二, 三个都 ...

Hello World

测试用文章

行列式具有良好的性质, 通常它是线性代数中较为基本的内容. 而行列式有非常直观的几何性质, 它是矩阵中以向量为棱的平行四边形 (六面体) 的有向体积, 当维数超过三维时, 有类似的结果, 我们可以称其为 “广义平行六面体” 的有向体积. 我们给出广义平行六面体体积的一个递归定义. 设 $A$ 为 $n\times n$ 矩阵, 其中第 $k$ 行向量 $L$ 即为广义平行六面体 $V$ 的一个棱,$$

\newcommand\xrule{\rule[.5ex]{2em}{.4pt}}

\left[\begin{matrix}

\xrule& L_1&\xrule\\\\

\xrule &L_2&\xrule\\\\

\vdots \\\\

\xrule &L_m&\xrule\\\\

\end{matrix}\right]=\left[\begin{matrix}

\xrule &H+G&\xrule\\\\

\xrule &L_2&\xrule\\\\

\vdots\\\\

\xrule &L_m&\xrule\\\\

\end{matrix}\right]

$$以 $ ...