《机器学习》 西瓜书习题 第 3 章: 线性模型

习题

3.1

试析在什么情况下式 $(3.2)$ 中不必考虑偏置项 $b$ .

书中有提到, 可以把 $x$ 和 $b$ 吸收入向量形式 $\hat{w} = (w;b)$ .此时就不用单独考虑 $b$ 了.

其实还有很多情况不用, 比如说使用了 $\mathrm{one-hot}$ 编码, 就可以不用考虑偏置项.

更广泛的情况是, 如果偏置项 $b$ 可以被 “包含” 在另外的一些离散特征里, 那么就不用考虑. 就是偏置项可以以一定系数加到离散特征中. (可能看了还是不太懂, 我以后有时间会重写一个的.)

3.2

试证明, 对于参数 $w$, 对率回归的目标函数 $(3.18)$ 是非凸的, 但其对数似然函数 $(3.27)$ 是凸的.

$$ y = \frac{1}{1 + e^{-(\boldsymbol w^\mathrm T\boldsymbol x + b)}}\tag{3.18} $$ $$ \ell(\boldsymbol\beta) = \sum^m_{i = 1}(-y_i\boldsymbol \beta^\mathrm T\boldsymbol{\hat{x}}_i)\tag{3.18} $$计算其海森矩阵, 判断是否正定. 海森矩阵可以类比成一元函数的二阶导, 正定可以类比为二阶导恒大于 $0$ .

3.3

编程实现対率回归, 并给出西瓜数据集 $3.0\alpha$ 上的结果.

3.4

选择两个 $\mathrm{UCI}$ 数据集, 比较 $10$ 折交叉验证法和留一法所估计出的错误率.

3.4

编程实现线性判别分析, 并给出西瓜数据集 $3.0\alpha$ 上的结果.

3.6

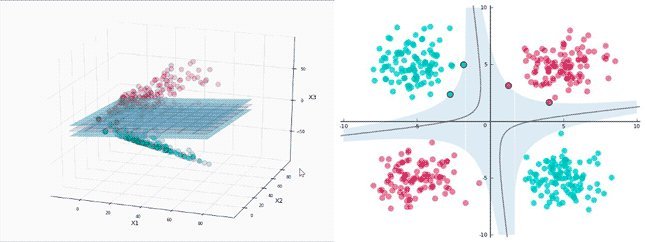

线性判别分析仅在线性可分数据上能获得理想结果, 试设计一个改进方法, 使其能较好地用于飞线性可分数据.

像 $6.3$ 节介绍的那样, 使用核函数, 就可以运用于非线性可分数据.

3.7

令码长为 $9$, 类别数为 $4$ , 试给出海明距离意义下理论最优的 $\mathrm{ECOC}$ 二元码并证明之.

首先要给出理论最优, 我们先要确定 ‘最优’ 的指导标准.

对同等长度的编码, 理论上来说, 任意两个类别之间的编码距离越远, 则纠错能力越强.

我们要将 ‘任意两个类别的编码距离’ 用数学表达, 这样才能进行求解. 那么怎么用数学表达这个 ‘距离’ 呢? 这里考虑到 ‘总体距离最大’ , 同时我们还要保证每两个类别之间的反码的距离也 ‘最大’ , 所以我们浅显的使用每两个类别之间的海明距离乘和其反码的海明距离的积来作为衡量标准(有点绕), 我们定义一个变量 $L$ 用来表达这个积, 也就是有

$$

L = \prod_{1\leqslant i< j\leqslant 4}dis(r_i, r_j)dis(r_i, -r_j)

$$

$dis(r_i, r_j)$ 表示第 $i$ 个编码和第 $j$ 个编码之间的海明距离, $dis(r_i, r_j)$ 表示第 $i$ 个编码和第 $j$ 个编码的反码之间的海明距离. $L$ 越大代表这种编码方式越好.

于是我写了段程序来搜索 $L$ 的最大值 (直接爆搜) .

1 |

|

结果:

| 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 |

|---|---|---|---|---|---|---|---|---|

| 1 | 1 | 1 | 1 | 1 | 1 | 1 | 1 | 1 |

| 1 | 1 | 1 | 1 | 0 | 0 | 0 | 0 | 0 |

| 1 | 1 | 0 | 0 | 1 | 1 | 1 | 0 | 0 |

| 1 | 1 | 0 | 0 | 1 | 0 | 0 | 1 | 1 |

64000000

当然我们要把 $0$ 换成 $-1$.

所以, 我们求出了海明距离下理论最优的, 码长为 $9$, 类别数为 $4$ 的 $\mathrm{EOOC}$ 二元码. 至于证明, 在我们定义的衡量标准下, 其正确性是显然的.

3.8*

$\mathrm{EOOC}$ 编码能起到理想纠错作用的重要条件是: 在每一位编码上出错的概率相当且独立. 试析多分类任务经 $\mathrm{EOOC}$ 编码后产生的二类分类器满足该条件的可能性及由此产生的影响.

$\mathrm{EOOC}$ 编码不仅要和其他编码距离尽量大, 还要和其他编码的反码距离也要大. 这是因为每个二类分类器的错误可能相似. 考虑一个极端情况, 要是错误完全相同, 那么分类器出错的后果就是输出码为原来的反码.

3.9

使用 $\mathrm{OvR}$ 和 $\mathrm{MvM}$ 将多分类任务分解为二分类任务求解时, 试述为何无需专门针对类别不平衡性进行处理.

原文就已经提到

对 $\mathrm{OvR}$ 、$\mathrm{MvM}$ 来说, 由于对每个类进行了相同的处理, 其拆解出的二分类任务中类别不平衡的影响会相互抵消, 因此通常不需要专门处理.

3.10*

试推导出多分类代价敏感学习 (仅考虑基于类别的误分类代价) 使用 “再缩放” 能获得理论最优解的条件.

原文中提到

再缩放的思想虽简单, 但实际操作却并不平凡, 主要因为 “训练集是真实样本总体的无偏采样” 这个假设往往并不成立.

因此假设成立应该也算是获得理论最优解的一个条件(好水啊).